- Введение

- Почему объяснимость алгоритмов важна?

- Основные причины важности объяснимости

- Статистика, подтверждающая важность

- Виды алгоритмов и их объяснимость

- Простые и прозрачные алгоритмы

- Сложные и непонятные алгоритмы (черные ящики)

- Проблема «черного ящика»

- Примеры из жизни

- Пример 1. Медицинская диагностика

- Пример 2. Кредитный скоринг

- Пример 3. Социальные сети и контент

- Преимущества объяснимости

- Сложности и ограничения

- Советы и рекомендации

- Авторское мнение

- Таблица: Сравнение объяснимости разных моделей

- Заключение

Введение

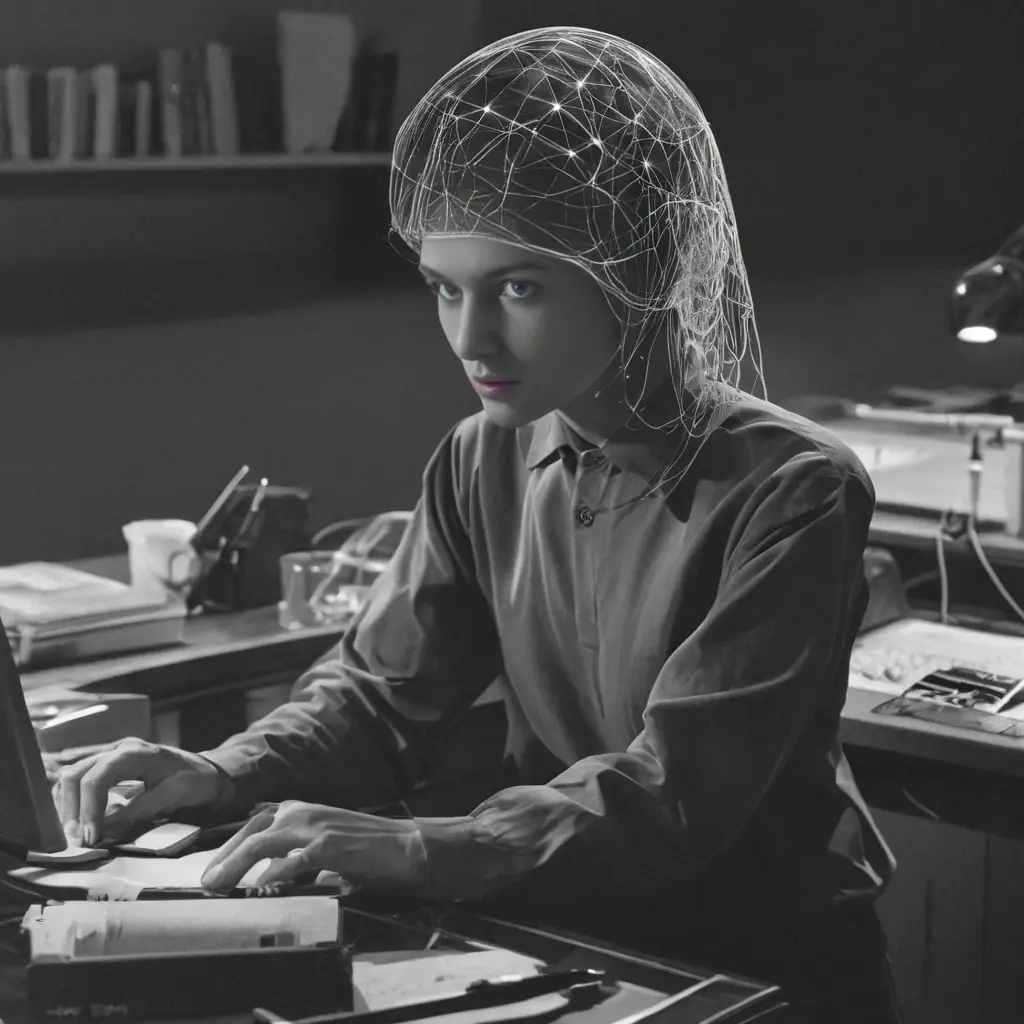

В современном мире алгоритмы играют ключевую роль практически во всех сферах жизни — от медицины и финансов до соцсетей и юриспруденции. Они принимают решения, влияющие на судьбы людей, и зачастую их решения кажутся непрозрачными и загадочными. В связи с этим общественность, специалисты и регуляторы задаются вопросом: должны ли алгоритмы объяснять свои решения в понятной человеку форме?

Почему объяснимость алгоритмов важна?

Объяснимость (или интерпретируемость) — это способность системы предоставлять понятные и обоснованные объяснения своих действий и решений. Для человека это означает, что можно понять логику, на основе которой алгоритм пришёл к выводу.

Основные причины важности объяснимости

- Доверие. Если пользователь понимает, как работает алгоритм, он скорее доверится результатам.

- Ответственность. Объяснимость помогает выявлять ошибки и дискриминацию, что особенно важно в юридических и медицинских системах.

- Контроль. Возможность проверить и скорректировать работу алгоритма даёт людям контроль над технологиями.

- Обучение и развитие. Понимание внутренней логики алгоритмов способствует их улучшению и развитию новых подходов.

Статистика, подтверждающая важность

| Область применения | % Пользователей, желающих объяснения | Главная причина |

|---|---|---|

| Медицина (искусственный интеллект для диагностики) | 85% | Понимание диагноза и вариантов лечения |

| Финансы (кредитные решения) | 78% | Избежание дискриминации и несправедливости |

| Социальные сети (рекомендательные системы) | 65% | Контроль над выводимым контентом |

| Юриспруденция (автоматизация правовых решений) | 90% | Прозрачность и возможность обжалования |

Виды алгоритмов и их объяснимость

Разные типы алгоритмов имеют разную степень интерпретируемости.

Простые и прозрачные алгоритмы

- Правила и деревья решений: легко объяснить, почему было принято конкретное решение — оно строится на простых логических правилах.

- Линейная регрессия, логистическая регрессия: коэффициенты моделей объясняют влияние каждого параметра.

Сложные и непонятные алгоритмы (черные ящики)

- Глубокие нейронные сети: их внутренняя логика и весовые параметры трудно свести к простому объяснению.

- Случайные леса или ансамбли моделей: тоже сложно интерпретировать из-за множества моделей внутри.

Проблема «черного ящика»

Такие алгоритмы принимают решения, не раскрывая своей логики, что создаёт опасность ошибок, дискриминации и потери доверия. Появляются технологии Explainable AI (XAI), нацеленные на создание объяснимых моделей, но полностью объяснить «черный ящик» пока сложно.

Примеры из жизни

Пример 1. Медицинская диагностика

Алгоритмы выявляют рак по снимкам МРТ. Врачи хотят понимать, почему алгоритм считает опухоль злокачественной, чтобы подтвердить диагноз. Без объяснения результаты сложно использовать в клинической практике.

Пример 2. Кредитный скоринг

Алгоритм оценивает кредитоспособность заемщика. Если отказан в кредите, человек имеет право узнать причины отказа. Отсутствие объяснений вызывает недовольство и несправедливость.

Пример 3. Социальные сети и контент

Рекомендательные системы предлагают контент. Пользователи часто не понимают, почему им показывается тот или иной пост. Объяснения помогают лучше контролировать персонализацию и бороться с распространением дезинформации.

Преимущества объяснимости

- Повышение пользовательского доверия и лояльности

- Улучшение качества решений через выявление ошибок

- Соответствие этическим и законодательным нормам

- Снижение рисков дискриминации и предвзятости

Сложности и ограничения

- Техническая сложность: объяснение сложно построить для глубоких моделей без существенного ущерба для точности.

- Проблема баланса: иногда простое объяснение уменьшает полноту и точность информации.

- Понятность: объяснения должны быть доступны разным аудиториям — от специалистов до обычных пользователей.

Советы и рекомендации

Разумный подход — это внедрение объяснимости по мере возможности и потребности. Не всегда нужно раскрывать все детали, достаточно предоставлять ключевые причины решения и возможные опции для пользователя.

Авторское мнение

«Алгоритмы, принимающие решения, влияющие на жизни людей, обязаны говорить с нами на одном языке. Объяснимость — не только техническая задача, но и социальный вызов, раз решать который мы должны вместе.»

— Эксперт по этике искусственного интеллекта

Таблица: Сравнение объяснимости разных моделей

| Тип модели | Простота объяснения | Точность | Область применения |

|---|---|---|---|

| Линейная регрессия | Высокая | Средняя | Экономика, медицина |

| Дерево решений | Высокая | Средняя/высокая | Кредитный скоринг, диагностика |

| Глубокая нейронная сеть | Низкая | Очень высокая | Компьютерное зрение, распознавание речи |

| Случайный лес | Средняя | Высокая | Финансы, маркетинг |

Заключение

Объяснимость алгоритмов — важнейший аспект их интеграции в социальную среду и повседневную жизнь. Она позволяет повысить доверие пользователей, обеспечивает возможность контроля за технологиями и помогает минимизировать риски ошибок и предвзятости. Хотя полная прозрачность «черных ящиков» пока недостижима, технологии Explainable AI и доступные объяснения — это шаг вперед. В конечном итоге, алгоритмы должны не лишь принимать решения, но и умело их объяснять, чтобы люди чувствовали себя уверенно в мире, где машинам доверено всё больше.